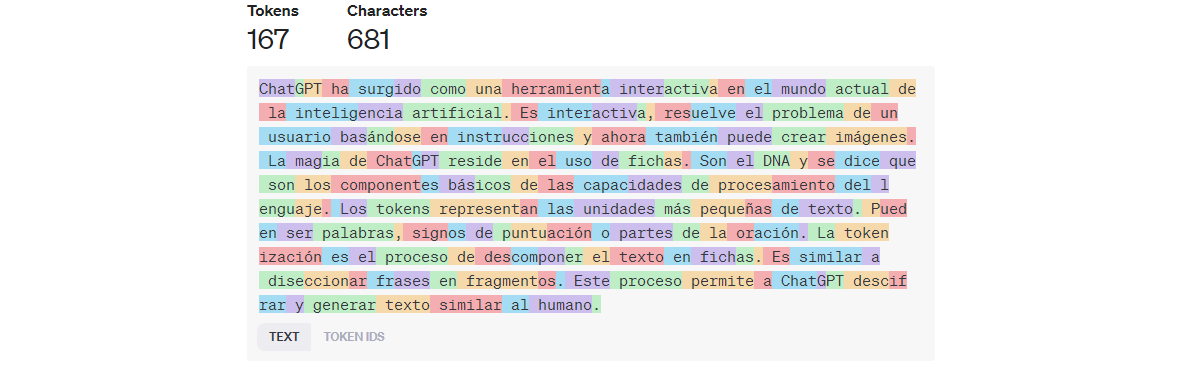

ChatGPT ha surgido como una herramienta interactiva en el mundo actual de la inteligencia artificial. Es interactiva, resuelve el problema de un usuario basándose en instrucciones y ahora también puede crear imágenes. La magia de ChatGPT reside en el uso de fichas. Son el DNA y se dice que son los componentes básicos de las capacidades de procesamiento del lenguaje.

Los tokens representan las unidades más pequeñas de texto. Pueden ser palabras, signos de puntuación o partes de la oración. La tokenización es el proceso de descomponer el texto en fichas. Es similar a diseccionar frases en fragmentos. Este proceso permite a ChatGPT descifrar y generar texto similar al humano.

Puede comprar las fichas y utilizar el GPT-4 avanzado, conocido por ser uno de los modelos más creativos, haciendo clic en este enlace.

Comprender la importancia de los tokens en los modelos lingüísticos de ChatGPT

Los tokens son más que meros fragmentos de texto. Ayudan a la IA a comprender el contexto y la semántica de un texto. Los tokens, que captan los matices del lenguaje, proporcionan respuestas pertinentes y coherentes. Cuando se trata de la diversidad y complejidad de la expresión humana, la tokenización mantiene un equilibrio. Pondera entre captar el significado y mantener la eficiencia de cálculo.

El proceso exacto de tokenización varía según los modelos. Modelos como GPT-3.5 y GPT-4 utilizan un tokenizador diferente en comparación con los modelos Codex o GPT-3 heredados. Para el mismo texto de entrada, cada uno producirá tokens diferentes.

Sin embargo, ChatGPT emplea la codificación por pares de bytes (BPE), que gestiona la inmensidad del lenguaje humano. Este método ayuda a mejorar la capacidad de aprendizaje del modelo al dividirlo en palabras comunes más pequeñas utilizando tokens más manejables. Es fundamental que este modelo gestione la complejidad del lenguaje para que ChatGPT sea preciso y eficaz.

¿Qué es un token?

En ChatGPT, los tokens son los elementos básicos del procesamiento del lenguaje. Pueden ser tan cortos como un carácter o tan largos como una palabra, pero son el texto más conciso que el modelo puede entender. Analizaremos la idea de los tokens en el chat bot de IA «GPT» y su importancia para el funcionamiento de este modelo lingüístico.

El proceso de tokenización

La tokenización es el proceso mediante el cual ChatGPT divide un fragmento de texto en elementos más pequeños llamados tokens. Este procedimiento es esencial para que el modelo pueda comprender y procesar eficazmente el lenguaje humano.

El método de tokenización consiste en:

- Descomposición del texto: ChatGPT divide cualquier texto de entrada en unidades que van desde un solo carácter hasta palabras enteras. La frase «ChatGPT es un modelo excelente«, por ejemplo, podría dividirse en tokens individuales como «Chat«, «G«, «PT«, «es«, «un«, «modelo«, «excelente«.

- Gestión de caracteres especiales: ChatGPT trata la puntuación, los espacios y los caracteres especiales como tokens independientes. Esto permite al modelo comprender la complejidad y organización del lenguaje escrito.

- Recuento de tokens: El modelo tiene en cuenta el «espacio» de estos tokens contándolos. Es esencial recordar que la capacidad del modelo es limitada y que cada ficha utiliza una parte de ella.

Contar Tokens

Es esencial contar los tokens cuando se trabaja con ChatGPT. Hay que ser consciente del número de tokens que se utilizan tanto para la entrada como para la salida. Por ejemplo, si su mensaje de entrada utiliza 10 tokens y el de salida 20, se le facturará un total de 30 tokens. Para ello, debes mantenerte dentro del límite de tokens del modelo y cuidar también la facturación. Puedes contar tokens utilizando librerías o API Response.

Bibliotecas

Puede utilizar una biblioteca para analizar el recuento de tokens del texto que se puede encontrar en GitHub. OpenAI proporciona Tiktoken, una biblioteca de Python, que no requiere que usted haga una llamada a la API. Puedes contar tokens en una cadena de texto usándola. También puede utilizar la versión en línea de este tokenizador en el sitio web de OpenAI.

Respuesta API

Al hacer una llamada API a ChatGPT, el número de tokens utilizados en la solicitud se indica en el campo de uso. De este modo, puede realizar un seguimiento del consumo de tokens.

Regla general

OpenAI ha establecido una regla general para la tokenización. Generalmente, un token, para un texto común en inglés, corresponde a ~4 caracteres de texto. Esto se convierte en 100 tokens = ~=75 palabras que se traduce aproximadamente a ¾ de una palabra.

Puede consultar la página Tiktoken para Python. Para JavaScript, el paquete soportado por la comunidad @dbdq/tiktoken funciona con la mayoría de los modelos GPT.

Estrategias para gestionar el uso de tokens

Puedes gestionar el uso de tokens asegurándote de que la conversación se ajusta al límite de tokens del modelo siguiendo estas estrategias:

- Elimine las preguntas menos relevantes de la conversación. Conserve el contexto necesario para que el modelo genere respuestas significativas.

- Reduzca el consumo de tokens manteniendo la concisión de las instrucciones.

- Utilice instrucciones a nivel de sistema para guiar al modelo a generar una respuesta específica. Por ejemplo, «[RESUMIR]».

Tokens y aplicaciones prácticas de ChatGPT

Tanto si presta servicios de atención al cliente como si utiliza herramientas de creación de contenidos o crea bots. Depende en gran medida de una tokenización eficiente. Sin embargo, cuando se trata de solicitudes basadas en texto largo, el modelo se ve restringido por el límite máximo de tokens.

Tamaño de la ventana de contexto

Los tokens pueden tomarse como trozos de palabras, donde 1000 tokens son unas 750 palabras. Sin embargo, a la hora de comparar, GPT-4 Turbo supera a GPT-4 en varios aspectos. GPT-4 Turbo tiene un contexto de 128.000, conocimientos frescos y potentes capacidades. Por otro lado, GPT-4 también es un modelo muy potente y tiene una ventana de contexto de 32.000 caracteres.

| Modelo | Ventana de contexto |

| GPT-4 | 32.000 |

| GPT-4V | 32.000 |

| GPT-3.5-turbo-1106 | 4096 |

Asistentes API

Los desarrolladores pueden construir sus propias aplicaciones utilizando Assistants API y herramientas como la recuperación y el intérprete de código. Cada asistente cobra una tarifa de almacenamiento de archivos de recuperación basada en los archivos pasados al asistente. Los tokens de Assistant API se facturan según las tarifas de entrada/salida por token del modelo lingüístico elegido. En el caso de los intérpretes de código, se cobran 0,03 $/sesión, que antes eran gratuitos hasta el 1/12/2023. En cambio, la recuperación cuesta 0,20 $/GB o asistente al día.

Modelos de ajuste fino

Cualquiera puede crear modelos personalizados afinando los modelos base con los datos de entrenamiento de OpenAI. A un usuario sólo se le facturarán los tokens utilizados en las peticiones a ese modelo. Por ejemplo, para GPT-3.5 Turbo, el entrenamiento costará 0,0080$/1K tokens, con 0,0030$ para la entrada y 0,0060$ para la salida.

El total de tokens se facturará según las tarifas de entrenamiento de los modelos de ajuste. Sin embargo, el número de tokens de entrenamiento depende del número elegido de épocas de entrenamiento y del conjunto de datos de entrenamiento.

Tokens en el archivo de entrenamiento * número de épocas de entrenamiento = tokens de entrenamiento totals.

| Modelo | Formación | Entrada Utilización | Salida Utilización |

| Davinci-002 | $0.0060/1K tokens | $0.0120/1K tokens | $0.0120/1K tokens |

| Babbage-002 | $0.0004/1K tokens | $0.0016/1K tokens | $0.0016/1K tokens |

Modelos de imagen y audio

Puedes crear imágenes y arte de alta calidad con DALL E 3 mientras que DALL E 2 está optimizado para un menor coste. Cuesta 0,040 $/imagen para una imagen estándar con una imagen de 1024×1024 mientras que 0,0080 $/imagen para una imagen de 1024×1792 y 1792×1024. Las imágenes HD cuestan 0,0080 y 0,120 dólares respectivamente.

El modelo Whisper puede transcribir voz a texto y traducir del inglés a otros idiomas.

| Modelo | De Uso |

| Whisper | 0,006 $/minuto |

| Texto a voz (estándar) | 0,015 $/1.000 caracteres |

| Texto a voz (HD) | 0,030 $/1.000 caracteres |

Conclusión

Los tokens son los bloques de construcción y la unidad fundamental de interacción en ChatGPT. Es necesario conocer a fondo el funcionamiento de las fichas, contarlas con precisión y gestionar su consumo. Esto ayudará a asegurar que tus prompts permanezcan dentro del límite de tokens del modelo.

Preguntas frecuentes (FAQs)

¿Qué es una ficha?

Los tokens son fragmentos o trozos de palabras que se utilizan en PNL. Un token equivale aproximadamente a 0,75 palabras. Puede experimentar con esto en la herramienta Tokenizer.

¿Qué modelo debo utilizar para contar tokens?

OpenAI recomienda utilizar GPT-3.5 Turbo o GPT-4. Depende únicamente de la complejidad de las tareas, sin embargo, generalmente GPT-4 realiza un rango más amplio de evaluaciones. GPT-3.5 ofrece resultados con baja latencia y menor coste/token.

¿Cómo puedo gestionar mis gastos en fichas?

Puedes establecer un presupuesto mensual en tu configuración de facturación. OpenAI dejará de servir las solicitudes. Sin embargo, es posible que se produzca un retraso en la aplicación del límite. El usuario será responsable de cualquier cargo por exceso en el que incurra.

¿Cuántos tokens tiene GPT-4?

El modelo GPT-4 estándar de OpenAI ofrece 8.192 tokens. Sin embargo, el GPT-4 (32K) puede admitir actualmente hasta 32.768 tokens.