GPT son las siglas de «Generative Pre-Trained Transformer», que utiliza el aprendizaje profundo y algoritmos especializados para encontrar patrones dentro de secuencias de datos y producir texto similar al humano.

ChatGPT es un chatbot de inteligencia artificial (IA) que crea diálogos conversacionales similares a los humanos mediante el procesamiento del lenguaje natural. Puede responder a preguntas y redactar varios tipos de contenido, como entradas de blog, publicaciones en redes sociales, artículos, ensayos, correos electrónicos e incluso código.

ChatGPT Español es la versión en español de ChatGPT, de uso gratuito y sin necesidad de registro. Se basa en el modelo GPT-3.5 Turbo e incluso ofrece el modelo GPT-4, que es uno de los más avanzados de IA, a un precio muy bajo.

GPT-2

GPT-2 es una versión anterior del modelo GPT lanzada el 14 de febrero de 2019. Obtuvo una gran atención por sus impresionantes capacidades de generación de texto. tEl modelo destaca por su tamaño, con 1.500 millones de parámetros. Este fue un aumento significativo con respecto al GPT-1, que tenía 117 millones de parámetros y se consideraba muy grande en su lanzamiento.

Con 1.500 millones de parámetros, GPT-2 puede generar respuestas coherentes y contextualmente relevantes sobre diversos temas. Se ha convertido en una opción popular para muchas aplicaciones de IA conversacional.

Según un artículo de James Vincent publicado en El bordeen febrero de 2019, «[la] escritura get-2 generalmente resulta fácilmente identificable como no humana»; siguió siendo «uno de los ejemplos más interesantes hasta ahora» de programas de generación de lenguaje.

GPT-2 tiene un límite máximo de tokens para sus entradas y salidas. El límite de tokens para GPT-2 es 1024 tokens. Esta restricción afecta la longitud del texto que puede manejar en una sola instancia. También utiliza un tokenizador de codificación de pares de bytes (BPE). Se puede ajustar en conjuntos de datos específicos para realizar mejor tareas, como la generación de lenguaje especializado o la respuesta a preguntas de dominios específicos.

El modelo se entrenó en un conjunto de datos diverso, WebText, obtenido de Internet, incluidos sitios web como Reddit, que lo ayudó a comprender y generar una amplia gama de tipos y estilos de texto. La capacitación implicó aprendizaje no supervisado, lo que significa que GPT-2 aprendió a predecir la siguiente palabra en una oración sin orientación específica sobre las tareas.

GPT-2 sentó las bases para modelos posteriores más grandes como GPT-3 y GPT-4. Estos modelos posteriores ampliaron las capacidades demostradas por GPT-2, ofreciendo una capacidad aún mayor y capacidades de generación de lenguaje más refinadas.

GPT-3

El 11 de junio de 2020, GPT-3, la tercera versión del modelo GPT, es un modelo de lenguaje innovador que ha superado los límites de lo que la IA puede lograr.Con sus 175 mil millones de parámetros, GPT-3 es significativamente más grande que GPT-2, que tiene 1,5 mil millones de parámetros. Esta escala masiva permite una comprensión más profunda y una generación de texto más matizada, lo que lo convierte en uno de los modelos de lenguaje más diversos disponibles.

Aprendizaje con pocas posibilidades y sin posibilidades

Una de las características más notables de GPT-3 es su capacidad para realizar tareas con poca o ninguna capacitación específica. Esta capacidad, conocida como aprendizaje de pocos intentos y de cero disparos, permite que GPT-3 comprenda y responda a diversas indicaciones y preguntas, lo que lo hace increíblemente versátil.

OpenAI ha proporcionado acceso a GPT-3 a través de una API, lo que permite a los desarrolladores integrar sus capacidades en diversas aplicaciones y servicios. Esta accesibilidad ha estimulado la innovación y el desarrollo de nuevas herramientas y servicios que aprovechan las capacidades avanzadas de procesamiento del lenguaje de GPT-3.

Límite de tokens

GPT-3 tiene un límite de tokens de 4096 tokens para cada secuencia de entrada y salida. Este es un aumento significativo con respecto al límite de tokens de GPT-2, lo que permite interacciones o generación de contenido más prolongadas y complejas.

Variantes del modelo GPT-3

GPT-3 está disponible en varias variantes; cada uno satisface diferentes necesidades computacionales y de rendimiento y se distingue por el recuento de parámetros.

- El más pequeño es Ada, con 125 millones de parámetros, diseñado para respuestas rápidas y menor uso de recursos.

- Con 1.300 millones de parámetros, babbage equilibra eficiencia y capacidad, lo que lo hace adecuado para aplicaciones de uso general.

- Curie, que contiene 6.700 millones de parámetros, es experto en tareas lingüísticas más complejas y ofrece capacidades de generación y comprensión matizadas. La variante más grande

- Davinci cuenta con 175 mil millones de parámetros, lo que proporciona el procesamiento de lenguaje más avanzado para procesos complejos y tareas creativas. Estas variantes permiten a los usuarios seleccionar el modelo más apropiado para sus requisitos específicos de precisión, profundidad y eficiencia computacional.

| Modelo | Alojamiento por horas | Fichas de entrada | Fichas de salida |

| Babbage-002 | EUR 1,56 | EUR 0,367 / 1k | EUR 0,004 / 1k |

| davinci-002 | EUR 2,754 | EUR 0,184 / 1k | EUR 0,020 / 1k |

| Ada | – | EUR 0,367 / 1K tokens | EUR 0.0367 / 1K tokens |

GPT-3.5

GPT-3.5, sin dejar de utilizar la amplia arquitectura de 175 mil millones de parámetros como GPT-3, se entrenó con datos hasta septiembre de 2021. Esto significa que incluye desarrollos, tendencias e información más recientes que GPT-3, introducido con datos hasta 2020. Este modelo tiene una ventana de contexto de 16.385 tokens. GPT-3.5 acepta mensajes de texto con ventanas de contexto de más de 4K.

Si bien conserva las aplicaciones versátiles de GPT-3, GPT-3.5 exhibe capacidades de aprendizaje adaptativo mejoradas, lo que lo hace más efectivo para escenarios de interacción dinámica y tareas complejas de resolución de problemas.

Los avances en GPT-3.5 subrayan una mejora continua en la capacidad de la IA para imitar la comprensión y la interacción humana en el procesamiento del lenguaje.

GPT-3.5 Turbo

OpenAI lanzó GPT-3.5 Turbo, lo que trae una nueva era de potentes modelos de lenguaje. La última versión representa un salto significativo en la producción y el análisis del lenguaje natural, basándose en la impresionante base establecida por su predecesor, GPT-3.5. Todos los usuarios se actualizarán automáticamente al modo turbo el 11 de diciembre de 2023.

A diferencia del GPT-3.5, el GPT-3.5 Turbo ofrece mejoras notables. Se presenta como un oponente formidable para los modelos lingüísticos impulsados por la IA. Una de las mejoras más notables de GPT-3.5 Turbo es su capacidad para analizar flujos de información más extensos. Todos los usuarios se actualizarán automáticamente al modo turbo el 11 de diciembre de 2023.

Una ventana de contexto de 16K es compatible de forma predeterminada en una versión reciente de GPT-3.5 Turbo. El nuevo 3.5 Turbo admite el modo JSON, llamadas de funciones simultáneas y un mejor seguimiento de instrucciones. Las evaluaciones internas revelan una mejora del 38 % en los trabajos relacionados con el seguimiento de formatos y la generación de YAML, JSON y XML.

Es digna de mención la rentabilidad del GPT-3.5 Turbo para un uso de gran volumen; Ofrece un costo por token más bajo que otros modelos, lo que lo convierte en una opción más económica para aplicaciones que procesan muchas solicitudes.

- Capacitación: EUR 0,006 / 1.000 tokens

- Entrada de uso: EUR 0,01/ 1K tokens

- Salida de uso: EUR 0,01/ 1K tokens

GPT-3.5 Turbo ofrece opciones de ajuste fino para una mayor personalización de tareas o industrias específicas para mejorar el rendimiento. Al ajustar el modelo, las empresas y los desarrolladores pueden adaptarlo mejor a determinadas actividades o iniciativas, mejorando su rendimiento para aplicaciones específicas. Este proceso le permite entrenar el modelo en su conjunto de datos, personalizando sus respuestas según sus necesidades.

Dos modelos forman parte de la familia GPT-3.5 Turbo: gpt-3.5-turbo-1106 admite una ventana de contexto de 16K y está optimizado para diálogo y gpt-3.5-turbo-instruct como modelo de instrucción con una ventana de contexto de 4K. Además, la API de Asistentes y las herramientas asociadas mejoran la facilidad de uso de los desarrolladores.

| Modelo | Costo de entrada | Costo de producción |

| gpt-3.5-turbo-1106 | EUR 0,001 por 1000 tokens | EUR 0,002 por 1000 tokens |

| gpt-3.5-turbo-instrucciones | EUR 0,001 por 1000 tokens | EUR 0,002 por 1000 tokens |

El último modelo de la serie GPT-3.5 Turbo, el GPT-3.5-Turbo-0125, ofrece ahora respuestas más rápidas y precisas que el GPT-4 y su homólogo Turbo. Mientras que el GPT-4 sigue destacando en tareas complejas con una mayor fiabilidad y creatividad, el GPT-3.5 actualizado presume ahora de una mayor precisión a la hora de producir respuestas en formatos específicos. Además, una reciente actualización ha resuelto un error que afectaba a la codificación del texto en las llamadas a funciones en idiomas distintos del inglés.

Los desarrolladores que deseen utilizar este modelo actualizado pueden hacerlo especificando «gpt-3.5-turbo-0125» como parámetro del modelo en sus solicitudes de API. Este modelo admite salidas JSON más fiables y viene con una ventana de contexto predeterminada de 16K.

El precio del GPT-3.5-Turbo-0125 se ha reducido significativamente, con una disminución del 50% a 0,50 dólares por 1 millón de tokens para la generación, y una reducción del 25% en los costes de salida a 1,50 dólares por 1 millón de tokens.

Los tres modelos anteriores de turbo get-3.5 apuntaban a gpt-3.5-turbo-16K, gpt-3.5-turbo-0613 y gpt-3.5-turbo-16k-0613. Aquí es donde OpenAI marcó estos modelos como «legacy» refiriéndose a los modelos y a los endpoints que ya no recibirán más actualizaciones. Señala a los desarrolladores que OpenAI se está moviendo y que probablemente deberían migrar a modelos o endpoints más nuevos.

GPT-4

GPT-4, lanzado en marzo, se basó en datos fechados hasta septiembre de 2021. Este modelo acepta entrada rápida tanto de texto como de imágenes. Admite una ventana de contexto de 32k (32.000 tokens). Según las últimas noticias, el menú desplegable GPT-4 pronto quedará obsoleto. GPT-4 no es accesible al público.

GPT-4, el avance más actual en modelos de lenguaje de IA, ha superado todos los modelos de lenguaje de IA anteriores. Una evaluación precisa del punto de referencia MMLU, un conjunto diverso de 14 000 preguntas de opción múltiple que abarcan 57 disciplinas y traducidas a varios idiomas mediante Azure Translate, reveló esta mejora en el rendimiento.

Notablemente, GPT-4 funcionó mejor en inglés que GPT-3.5 en 24 de los 26 idiomas evaluados, incluidos idiomas como el letón, el galés y el suajili, que históricamente han contado con menos recursos. Sus principales características incluyen;

- Capacidades de entradas visuales mejoradas

- Función de direccionabilidad

- Creatividad y colaboración mejoradas

La estructura de costos de los tokens de entrada y salida para GPT-4 y su variante GPT-4-32k es la siguiente;

| Modelo | Costo de entrada | Costo de producción |

| GPT-4 | 0,03 USD por 1000 tokens | 0,06 dólares por 1.000 tokens |

| GPT-4-32k | 0,06 dólares por 1.000 tokens | 0,12 dólares por 1.000 tokens |

GPT-4 Turbo

El modelo de última generación es el GPT-4 Turbo. Es más potente, incluye una ventana de contexto de 128k (el equivalente a 300 páginas de texto en un solo mensaje) y tiene una fecha límite de conocimiento actualizada de abril de 2023. En comparación con el modelo GPT-4 anterior, el modelo es 2 veces más barato para fichas de salida y 3 veces más barato para tokens de entrada. Para este modelo, 4096 tokens de salida son el máximo.

Con su capacidad de contexto de 128k, el GPT-4 Turbo es una mejora con respecto al GPT-4, ya que proporciona información más reciente y funciones ampliadas a un precio más asequible.

| Modelo | Costo de entrada | Costo de producción |

| gpt-4-1106-vista previa | 0,01 USD por 1000 tokens | 0,03 USD por 1000 tokens |

| gpt-4-1106-vista-vista previa | 0,01 USD por 1000 tokens | 0,03 USD por 1000 tokens |

Este modelo puede ser utilizado por cualquier persona que tenga acceso GPT-4 y una cuenta API OpenAI. Se puede acceder al modelo proporcionando gpt-4-1106-preview como nombre del modelo en la API.

GPT-4V(ision)

El 25 de septiembre de 2023, GPT-4 con visión (GPT-4V) es la característica más reciente que estamos poniendo ampliamente a disposición, que permite a los usuarios dirigir GPT-4 para analizar las entradas visuales proporcionadas por el usuario. GPT-4 con visión está abierto a todos los desarrolladores que tengan GPT-4. Sin embargo, la API de Wizards actualmente no admite la entrada de imágenes.

Aunque GPT-4 con visión es potente, no puede interpretar imágenes médicas (CAT), alfabetos no latinos, captchas ni textos grandes. El costo de la entrada de imágenes se calcula en función del tamaño y detalle de la imagen.

La característica más reciente que estamos lanzando ampliamente es GPT-4 con visión (GPT-4V), que permite a los usuarios decirle a GPT-4 cómo evaluar las entradas de imagen que suministran. Algunos ven la integración de modalidades adicionales, como entradas visuales, en grandes modelos de lenguaje (LLM) como un área crucial para futuros estudios y desarrollo en inteligencia artificial.

Con funciones e interfaces adicionales, los LLM multimodales pueden aumentar la influencia de los sistemas exclusivamente lingüísticos, ayudarlos a abordar nuevos problemas y brindar a sus usuarios nuevas experiencias.

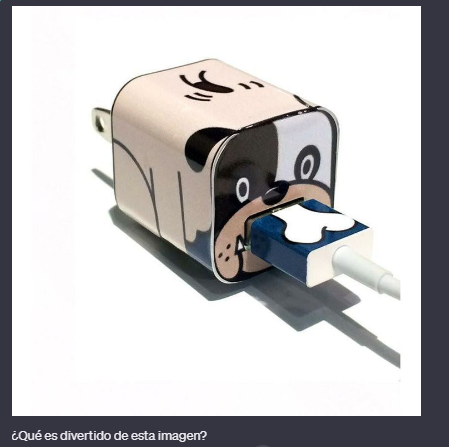

GPT 4-Vision responderá analizando la imagen:

Whisper

Un modelo de reconocimiento automatizado de voz (ASR) llamado Whisper fue capacitado utilizando 680.000 horas de datos multilingües y multitarea supervisados obtenidos en la web. La utilización de un conjunto de datos de este tamaño y variedad mejora la resistencia al ruido de fondo, los acentos y la jerga técnica.

Es capaz de transcribir voz en varios idiomas y traducir idiomas distintos del inglés al inglés. OpenAI ha creado los modelos y el código para ejecutar la inferencia con Whisper de código abierto, lo que puede facilitar el desarrollo de aplicaciones prácticas y una mayor investigación en el procesamiento del habla.

El modelo de precios de Whisper, el sistema de reconocimiento de voz de OpenAI, se basa en su tiempo de uso. Cuesta EUR 0,006 por minuto de audio procesado, con el tiempo redondeado al segundo más cercano. Esto significa que cuando usa Whisper para transcribir voz o traducir idiomas al inglés, se le cobra según la duración del archivo de audio que procesa, calculado en minutos.

La estructura de precios por minuto hace que sea sencillo estimar los costos de uso de Whisper en diversas aplicaciones, especialmente en escenarios que requieren procesamiento de audio frecuente o a gran escala.

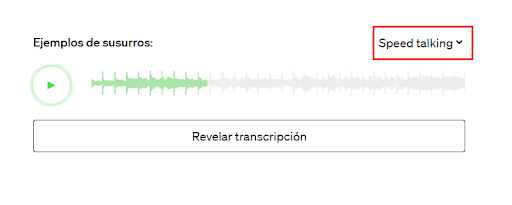

La función de «habla rápida» de Whisper se refiere a su capacidad para manejar audio con diferentes velocidades de habla. La formación avanzada de Whisper le permite procesar y transcribir el habla hablada de forma rápida o eficaz.

Esta característica es útil en diversos escenarios del mundo real donde el ritmo del habla puede variar significativamente, como en diferentes contextos lingüísticos, estados emocionales o tipos de contenido multimedia. El entrenamiento del modelo en un conjunto de datos grande y diverso garantiza que pueda transcribir y traducir el habla con precisión, independientemente de la velocidad a la que se pronuncie.

Análisis de diferencias y similitudes entre modelos GPT

El desarrollo de modelos de transformadores generativos preentrenados (GPT) por parte de OpenAI representa una progresión significativa en el procesamiento del lenguaje natural (NLP). Cada iteración, desde GPT 3 hasta GPT-4V, marca avances sustanciales en la complejidad, versatilidad y capacidad del modelo para comprender y generar texto similar al humano.

El análisis de las diferencias y similitudes entre estos modelos resalta la rápida evolución de las capacidades de la IA y arroja luz sobre sus posibles aplicaciones y los desafíos inherentes a su desarrollo.

| Modelo | Parámetros | Límite de datos de entrenamiento | Ventana de contexto | Características especiales | Casos de uso |

| GPT-2 | 1,5 mil millones | Hasta febrero de 2019 | 1.024 fichas | Primero, demostrar amplias capacidades. | Tareas de lenguaje general, asistencia de escritura. |

| GPT-3 | 175 mil millones | Hasta octubre de 2020 | 4.096 fichas | Aprendizaje avanzado de pocas oportunidades | Amplia gama de tareas, incluida la traducción y la creación de contenidos. |

| GPT-3.5 | 175 mil millones | Hasta septiembre de 2021 | 8.192 fichas | Contexto y comprensión refinados | Conversaciones más matizadas, aplicaciones profesionales |

| GPT-3.5 Turbo | No especificado | Hasta abril de 2023 | 16.385 fichas | Optimizado para el diálogo a un menor costo | Chatbots, atención al cliente. |

| GPT-4 | No especificado | No especificado | 8192 fichas | Capacidades multimodales | Tareas complejas, razonamiento, contenido creativo. |

| GPT-4 Turbo | No especificado | Hasta abril de 2023 | 128.000 fichas | Más barato con conocimientos más frescos | Aplicaciones de alta capacidad, investigación. |

| Whisper | No especificado | No especificado | No aplica | ASR multilingüe, resistente a acentos/ruido | Transcripción de voz, traducción de idiomas. |

Personalización de los modelos GPT

OpenAI permite ajustar modelos GPT en función de conjuntos de datos o casos de uso específicos. Esto permite a los desarrolladores e investigadores adaptar modelos a sus dominios, lo que permite conversaciones más especializadas y enfocadas. La personalización permite a los usuarios mejorar el rendimiento de los modelos GPT en aplicaciones específicas.

Esta formación improvisada puede mejorar la precisión, relevancia y eficacia del modelo a la hora de generar respuestas adecuadas. Es una herramienta poderosa para empresas y desarrolladores que requieren un alto grado de especificidad.

Además, el ajuste puede ayudar a mitigar algunos de los sesgos inherentes a los conjuntos de datos más amplios en los que se entrenan inicialmente los modelos GPT al enfatizar los datos representativos del dominio objetivo.

Elegir el modelo GPT adecuado

Al seleccionar un modelo GPT para GPT Chat, considere los siguientes factores:

- Requisitos de la tarea: Evalúe los requisitos específicos de su aplicación de IA conversacional. Determine la complejidad de la tarea, la calidad de respuesta deseada y las limitaciones de recursos.

- Tamaño y capacidad del modelo.: El tamaño del modelo GPT afecta su rendimiento y requisitos de recursos. Los modelos más grandes, como el GPT-3, ofrecen capacidades más avanzadas pero requieren más recursos computacionales.

- Necesidades de personalización: Si su aplicación requiere conversaciones de dominio específico o ajustes en conjuntos de datos específicos, considere la flexibilidad y las opciones de personalización que brindan los modelos GPT.

Conclusión

ChatGPT ofrece diferentes modelos de GPT, incluidos GPT-3.5, Turbo y GPT-4, cada uno con fortalezas y características. Estos modelos brindan varias opciones para que los desarrolladores e investigadores creen aplicaciones de IA conversacional que se adapten a sus necesidades. Como AI continúa innovando e introduciendo nuevos modelos como GPT-4 Turbo y Vision, las posibilidades de la IA conversacional se expandirán aún más.

Preguntas frecuentes (FAQs)

Puede GPT-3.5 Turbo manejar imágenes como GPT-4?

No, GPT-3.5 Turbo está optimizado para texto y diálogo, no para procesamiento de imágenes. GPT-4 introdujo la capacidad de procesar imágenes.

Existe alguna forma de probar GPT-4 gratis?

Según la información proporcionada, GPT-4 no está disponible para el público de forma gratuita. El acceso normalmente requiere una cuenta API de OpenAI y puede generar costos.

Cómo funciona GPT-4 en comparación con modelos anteriores en idiomas distintos del inglés?

GPT-4 ha mostrado un rendimiento mejorado en varios idiomas, incluso en aquellos con menos recursos históricamente, superando a GPT -3.5 en muchos casos.

Qué implica el ‘ajuste’ de los modelos GPT?

El ajuste implica entrenar el modelo en un conjunto de datos específico para personalizar sus respuestas para tareas o industrias particulares, mejorando el rendimiento y la relevancia.

Pueden los modelos GPT generar contenido creativo como poesía o letras de música?

Sí, los modelos GPT, especialmente los más grandes como GPT-3 y GPT-4, pueden generar una amplia gama de contenido creativo, incluidas poesía y letras musicales.