Aquí puedes usar ChatGPT impulsado por el nuevo y último modelo GPT-4o de OpenAI. Utiliza la API oficial de GPT-4o para servir el modelo completamente gratis y sin registro.

Qué es GPT-4o (Omni)?

Un desarrollo importante en este año de OpenAI es GPT-4o, que fue lanzado a mediados de mayo de 2024. Es su modelo insignia más reciente, con una fecha límite de conocimiento de octubre de 2023 y un contexto de 128K.

El GPT-4o puede manejar una gran variedad de entradas y salidas, a diferencia de las versiones anteriores. Se pueden obtener resultados y proporcionar información mediante texto, audio, fotos e incluso películas.

Cuando se trata de audio, GPT-4o puede reaccionar instantáneamente, como cuando las personas hablan. Su tiempo de respuesta a las entradas de audio es de 232 milisegundos de media, con un máximo de 320 milisegundos; esto es comparable al tiempo medio de respuesta humana durante una conversación.

Funciona mejor en tareas basadas en texto que su predecesor, el GPT-4, especialmente cuando se trata de idiomas distintos del inglés.

También es mucho más rápido y barato de utilizar. La principal ventaja de GPT-4o es su excelente comprensión de las señales visuales y auditivas, mejor que la de los modelos anteriores.

Cómo acceder a GPT-4o?

GPT-4o se está extendiendo actualmente a los usuarios de ChatGPT Plus y Team, dando prioridad a los clientes de pago.

Tras la finalización de esta implementación, también empezará a aparecer ChatGPT gratuito. En esta edición «monótona» sólo se incluyen las nuevas funciones relacionadas con el texto y las imágenes.

Sigue habiendo ventajas para los usuarios de pago respecto a los gratuitos, como un mayor límite de peticiones. El 3 de septiembre de 2024, OpenAI actualizó el modelo GPT-4o. La nueva versión incorpora mejor los archivos cargados y actualiza la memoria con las conversaciones de los usuarios, lo que ayuda a que las futuras interacciones sean útiles y relevantes.

Ese mismo mes, el 24 de septiembre, se incorporó la voz avanzada a las capacidades de audio de GPT-4o. Las conversaciones en tiempo real interpretaban señales no verbales, como la velocidad del habla, y respondían con emoción. Las funciones de voz avanzadas (incluida la entrada y salida de audio) estaban disponibles para los usuarios Plus y Team con un uso diario limitado.

Diferencia entre GPT-4o y GPT-4? Qué modelo es mejor?

La GPT-4o es una versión mejorada de la serie GPT, con funciones multimodales, velocidad y rendimiento mejorados.

Capacidades Multimodales

A diferencia de GPT-4, que se centra exclusivamente en el texto, GPT-4o combina la capacidad de procesar y producir resultados a partir de entradas textuales, visuales y auditivas.

Se seleccionaron 20 idiomas para ofrecer una representación de la compresión del nuevo tokenizador en varias familias lingüísticas.

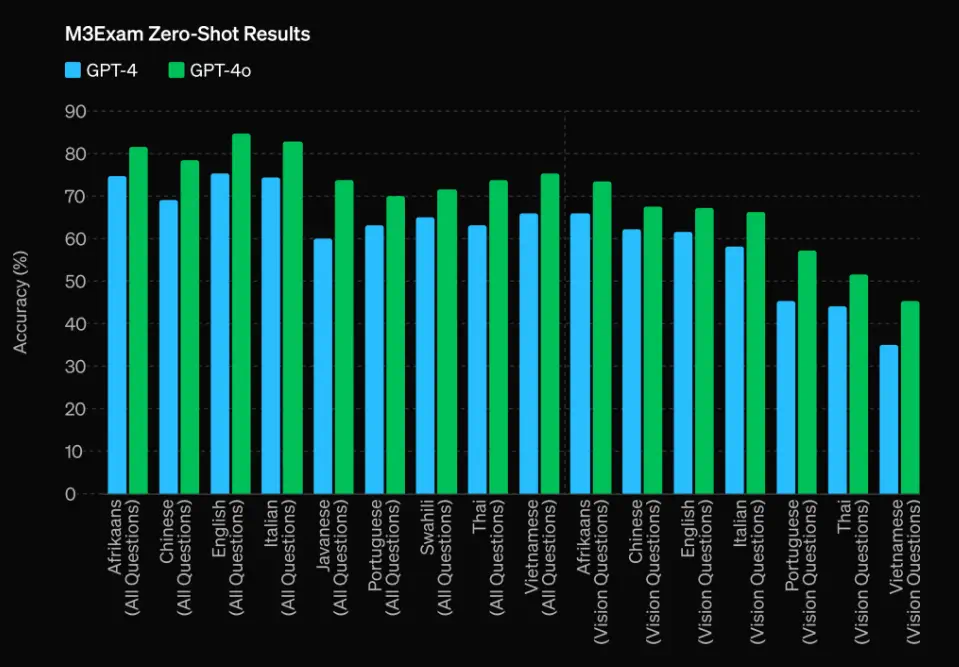

GPT-4o supera a GPT-4 en M3Exam, que es la evaluación lingüística y visual que consiste en preguntas de opción múltiple extraídas de exámenes estandarizados de varios países, en ocasiones acompañadas de imágenes y diagramas.

En esta prueba, GPT-4o supera a GPT-4 en todos los idiomas. Se excluyen los resultados de visión en swahili y javanés, ya que sólo hay cinco o menos preguntas de visión en estos idiomas.

Rendimiento y Velocidad

En comparación con GPT-4, se dice que GPT-4o es considerablemente más rápido y rentable, ya que responde con mayor rapidez y gestiona mayores cantidades de datos de forma más eficaz.

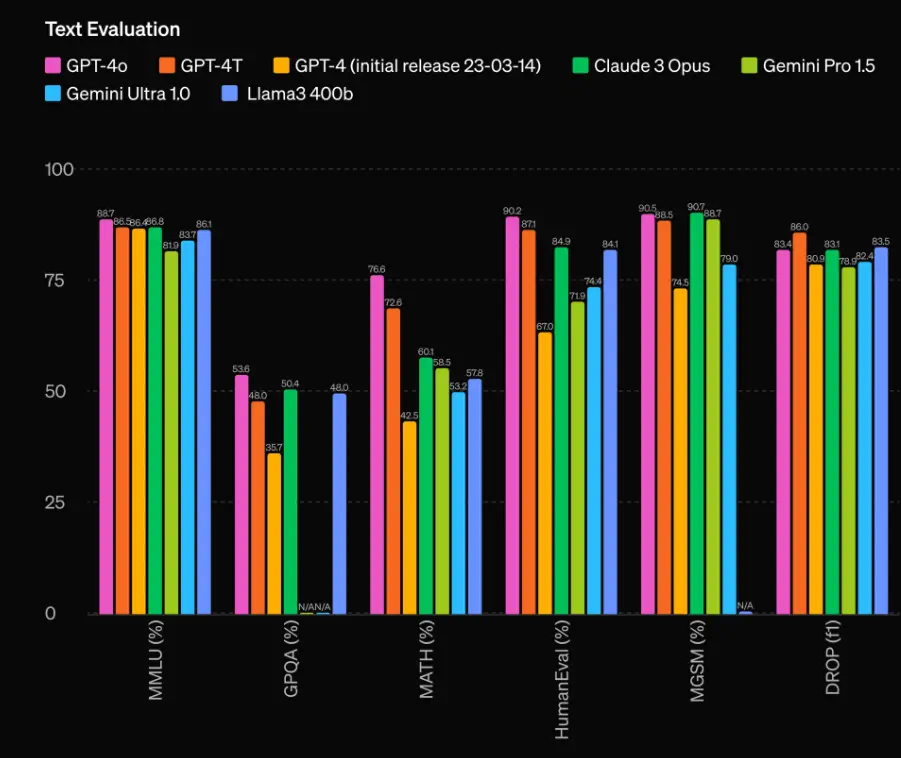

En lo que respecta a las MMLU de 0 tiros COT (preguntas de conocimientos generales), GPT-4o establece una nueva puntuación máxima del 88,7%. Además, GPT-4o establece una nueva puntuación máxima del 87,2% en el MMLU estándar de 5 preguntas sin COT.

Capacidades de Visión

A diferencia de GPT-4, GPT-4o puede comprender y analizar datos visuales, lo que aumenta su utilidad para tareas que implican medios mixtos o imágenes.

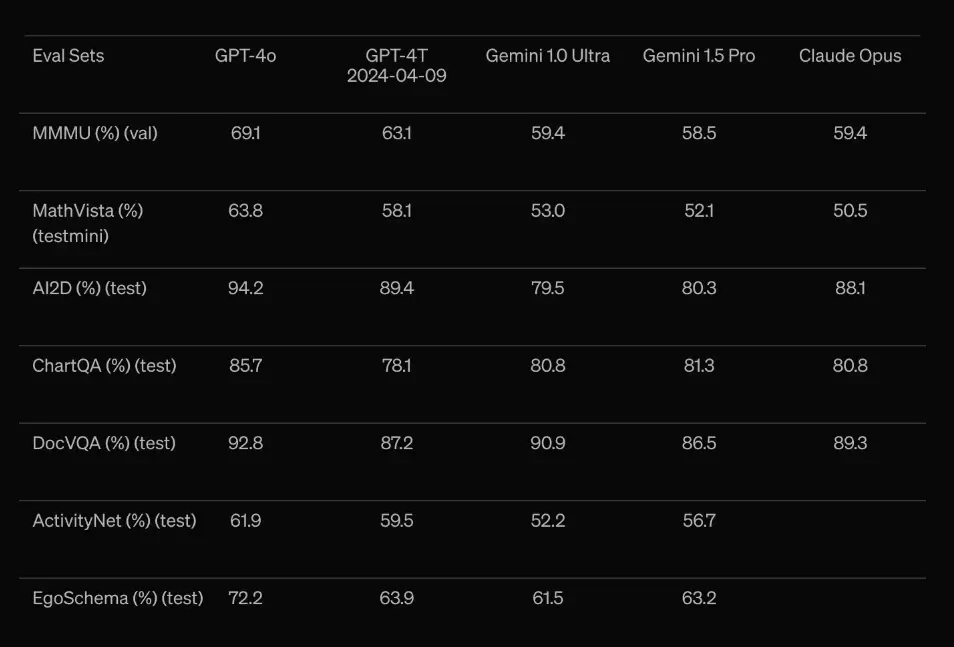

GPT-4o es el mejor de su clase en lo que se refiere a pruebas de percepción visual. Con MMMU, MathVista y ChartQA como CoT 0-shot, todas las evaluaciones de visión son 0-shot.

No sólo eso, sino que GPT-4o ha superado a GPT-4 en varias pruebas de referencia (como MMLU y HumanEval), demostrando un mejor rendimiento en tareas que requieren multilingüismo y razonamientos complicados.

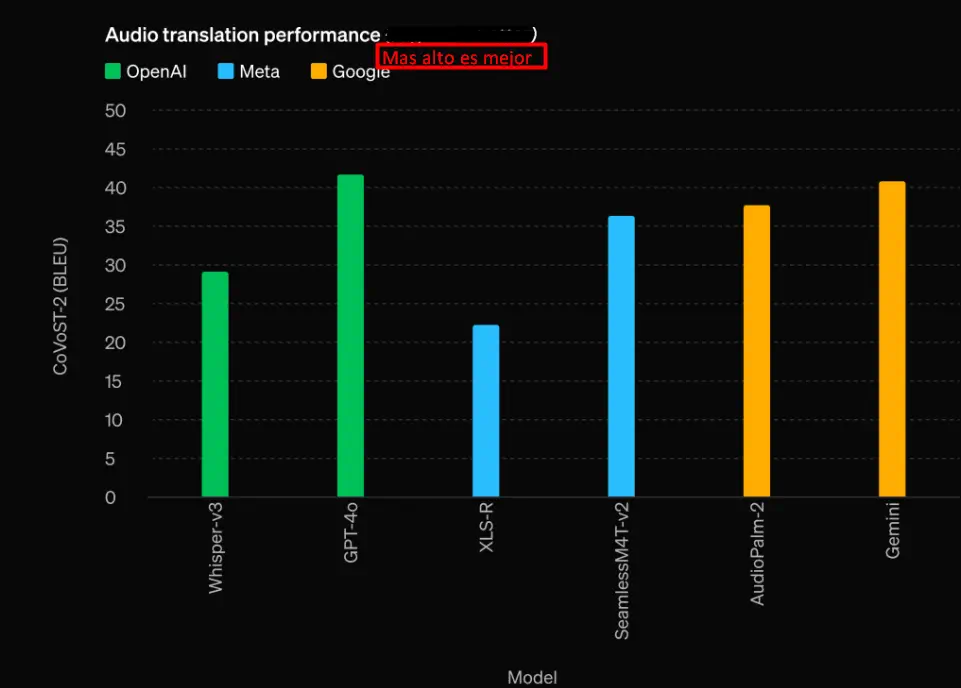

Rendimiento de la traducción de audio

Para evaluar la eficacia de varios modelos de IA, se realizaron tareas de traducción de audio utilizando la puntuación BLEU en modelos de OpenAI, Meta y Google.

Los modelos examinados fueron Audiopalm-2 y Gemini de Google, Whisper v3 y GPT-4o de OpenAI, y XLS-R y SeamlessMW47v2 de Meta.

Según los resultados, Whisper v3, Audiopalm-2 y Gemini obtuvieron los mejores resultados, con unos 45 puntos BLEU.

Le sigue SeamlessMW47v2 con 35 puntos, XLS-R con 25 y GPT-40 con 20. La mayor precisión en la traducción de audio se refleja en las puntuaciones BLEU más altas, con Whisper v3 de OpenAI, Audiopalm-2 de Google y Gemini a la cabeza.

Estos resultados implican que los modelos de Google y OpenAI funcionan bien para aplicaciones que necesitan una traducción de audio de alta calidad. Las discrepancias de rendimiento pueden atribuirse a cambios en los datos de entrenamiento, la arquitectura y las estrategias de optimización.

| Característica | GPT-4 | GPT-4o |

| Modalidades admitidas | Sólo texto | Texto, visual, audio |

| Velocidad de respuesta | Estándar (1 minuto y 10 segundos para 488 palabras) | Más rápido (12 segundos para 488 palabras) |

| Capacidades de visión | Ninguno | Funciones de visión avanzadas |

| Rendimiento multilingüe | Bueno para el inglés, básico para otros idiomas | Mejorado para varios idiomas, incluido el no inglés |

| Precios por uso de la API | Más caro | Más económico (la mitad que el GPT-4) |

| Indicadores de rendimiento | Puntuaciones más bajas en los puntos de referencia | Mejores resultados en evaluaciones comparativas como MMLU y HumanEval |

| Acceso web | Incluye acceso a Internet | Sin acceso web; sólo utiliza datos hasta octubre de 2023 |

| Interfaz de aplicación | Interfaz estándar ChatGPT | Accesible a través de ZenoChat para funciones mejoradas |

| Velocidad API | Generación más lenta de fichas de salida | Más rápido tanto en los tokens de entrada como en los de salida |

| Capacidad multitarea | Limitado a tareas basadas en texto | Capaz de manejar multitareas complejas que incluyan datos sonoros y visuales. |

Para los usuarios que desean funciones de interacción multimodal, tiempos de respuesta más rápidos y un mejor manejo de los contenidos multilingües, GPT-4o parece ser una gran actualización con respecto a GPT-4.

Funciona especialmente bien para aplicaciones avanzadas que necesitan integrar el procesamiento de datos en tiempo real de texto, gráficos y audio.

Características asombrosas de GPT-4o: Gráficos, Imágenes, Excel y Más

La creación más reciente de OpenAI, GPT-4o, está superando los límites de la inteligencia artificial. Este modelo incorpora características avanzadas que hacen uso de datos multimodales, como texto, gráficos y audio, para mejorar la interacción con el usuario y simplificar tareas difíciles.

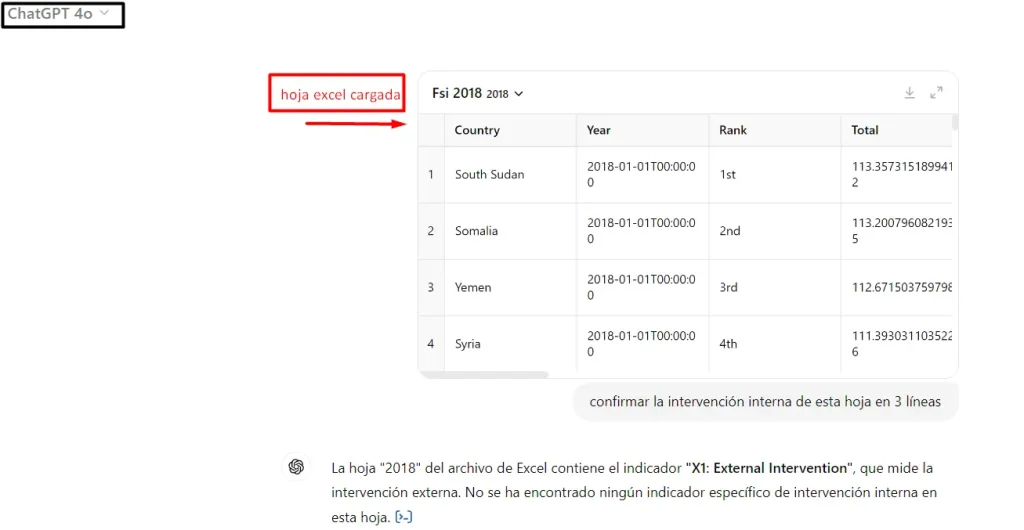

Capacidad analítica

Los usuarios pueden cargar y trabajar directamente con documentos de Excel o Google Sheets utilizando GPT-4o. Los usuarios pueden hacer preguntas complejas sobre la información de estos documentos, como confirmar las cifras de una previsión de marketing. Esta capacidad facilita la gestión de grandes conjuntos de datos y es especialmente útil para el análisis de datos.

Infografía Comprensión

Las infografías también pueden entenderse e interpretarse con GPT-4o. El objetivo de esta función es ayudar a los consumidores a comprender información compleja que se muestra gráficamente, como las infografías.

Por ejemplo, un usuario puede pedir a GPT-4o que aclare el texto de una infografía que contenga más de 100 números. Para los profesionales y estudiantes que trabajan a menudo con visualizaciones de grandes volúmenes de datos, esta capacidad no tiene precio.

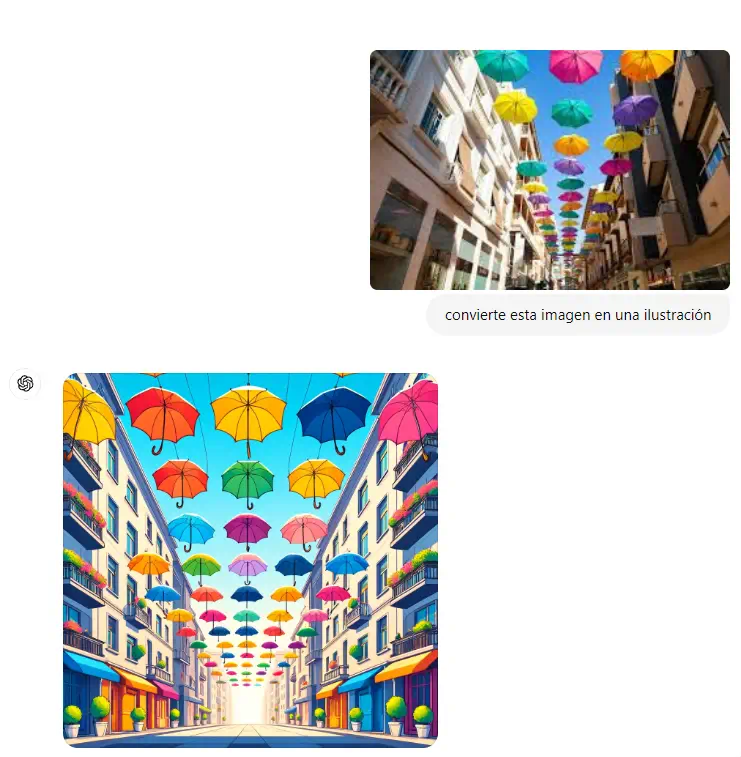

Convierte imágenes en diferentes estilos

Con ChatGPT-4o model, los usuarios pueden enviar una foto tomada por ellos mismos y pedir a la IA que la modifique para que se ajuste a la estética específica que deseen.

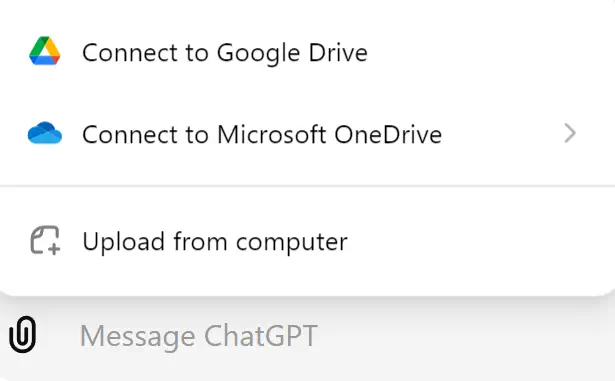

Adjuntar archivos desde la unidad

Ahora puedes elegir tus archivos de otros lugares para añadirlos a GPT-4o. Te permite conectar Google Drive y Microsoft OneDrive para que puedas añadir tus hojas de Excel, documentos de google o incluso imágenes directamente.

GPT-4o API Precios

El precio de la API de GPT-4o es más ventajoso que el de GPT-4, con precios más baratos de los tokens de entrada y salida.

La API GPT-4o se factura en función de la cantidad de tokens gestionados, mediante un sistema de pago por uso. GPT-4o tiene un precio más razonable gracias a su reducción de costes del 50% respecto a versiones anteriores como GPT-4.

Sin embargo, algunas personas de la comunidad de desarrolladores de OpenAI afirman que GPT-4o (a través de playground & API) utiliza muchos más tokens que GPT-4 Turbo.

Esta disparidad podría deberse a variaciones en la forma en que los distintos modelos gestionan tareas específicas, como el procesamiento de entradas y la búsqueda de archivos.

| Modelo | Entrada | Salida |

| GPT-4o | 4,61 euros/1 millón de fichas | 13,82 euros/1 millón de fichas |

| GPT-4o-2024-05-13 | 4,61 euros/1 millón de fichas | 13,82 euros/1 millón de fichas |

GPT-4o Seguridad y limitaciones

Para garantizar que el modelo tenga menos probabilidades de proporcionar resultados inadecuados, se filtra el material peligroso del conjunto de datos de entrenamiento. El comportamiento del modelo se mejora aún más para ajustarse a los procedimientos de seguridad tras el entrenamiento inicial.

GPT-4o fue evaluado en cuanto a persuasión, autonomía del modelo, ciberseguridad y peligros relacionados con materiales químicos, biológicos, radiológicos y nucleares (QBRN). El GPT-4o no recibió una calificación superior a riesgo medio en ninguna de estas evaluaciones.

Esto implica una estrategia metódica para reducir los posibles riesgos. A lo largo de la fase de entrenamiento del modelo, se emplearon evaluaciones automáticas y humanas para evaluar las versiones anteriores y posteriores a la reducción de la seguridad.

Incluso con varias precauciones de seguridad, hay algunas restricciones en todas las modalidades del modelo.

Disponibilidad de GPT-4o

Las funciones de texto e imagen de GPT-4o están empezando a aparecer en ChatGPT. Los usuarios Plus ya pueden acceder a GPT-4o con restricciones de mensajes hasta cinco veces superiores, así como en la versión gratuita.

En las próximas semanas, OpenAI lanzará una versión alfa del Modo Voz con GPT-4o dentro de ChatGPT Plus.

GPT-4o está actualmente disponible para los desarrolladores a través de la API como modelo de texto y visión. En comparación con GPT-4 Turbo, GPT-4o es el doble de rápido, la mitad de caro y tiene límites de velocidad cinco veces superiores.

En las próximas semanas, queremos poner a disposición de unos pocos socios de confianza las funciones mejoradas de audio y vídeo de GPT-4o a través de la API.

Preguntas más frecuentes (FAQs)

Cómo puede utilizarse ChatGPT 4o?

ChatGPT 4o admite entradas de texto, imágenes y voz. Es capaz de realizar análisis de datos, comprensión e interpretación de imágenes complicadas, transformación de imágenes y reacciones multilingües adecuadas al contexto.

Qué funciones ofrece la API GPT-4o?

Con la ayuda de la API GPT-4o, los programadores pueden incorporar sofisticadas funciones de IA a sus aplicaciones, como generación y procesamiento de texto, análisis e interpretación de imágenes y gestión de entradas de audio. También admite tareas complejas como análisis de datos, experiencias de usuario interactivas y producción de contenidos.

Es GPT-4o superior a GPT-4?

Sí, GPT-4o es una versión mejorada que ofrece una mayor funcionalidad, tiempos de reacción más rápidos y compatibilidad con entradas multimodales (texto, gráficos y audio). En comparación con GPT-4, también ha mejorado las medidas de seguridad y es más preciso en diversas actividades.

Cómo se utiliza ChatGPT 4o voice?

Sólo tienes que utilizar un navegador web para iniciar sesión en tu cuenta de ChatGPT e intentar acceder a GPT-4o. Busca la opción GPT-4o en el menú desplegable de la esquina superior izquierda, que está marcada como el «modelo más nuevo y avanzado» de OpenAI.» Al registrarte aceptas nuestras Condiciones de uso y Política de privacidad.

Es capaz GPT-4o de traducir idiomas en tiempo real?

Sí, GPT-4o es capaz de realizar traducciones orales y textuales en tiempo real. Esto lo hace extremadamente útil para aplicaciones como atención al cliente, reuniones internacionales y desarrollo de contenidos multilingües que requieren una comunicación instantánea en varios idiomas.

Cómo se mantiene la seguridad de las salidas de audio de GPT-4o?

Para sus salidas de audio, GPT-4o incorpora funciones de seguridad como limitadores de voz programados y estrictas normas de seguridad que deben cumplirse. Estas medidas de seguridad pretenden frenar el uso indebido de las capacidades de creación de audio, garantizando que los resultados sean adecuados y seguros.